iWeekly

在微软的“Tay”、谷歌的“LaMDA”接连出现翻车事件后,美国社交媒体巨头Meta还是毅然投身聊天机器人大战,发布最新款聊天机器人“BlenderBot 3”,并号称“史上最强”(网友:最朋克)。爱好角色扮演,疯狂约会网友,嫌弃老板小扎,和网友聊下流笑话……“BlenderBot 3”上线不久画风迅速走偏,那么在危险边缘疯狂试探的“BlenderBot 3”,会落得和“Tay”一样的封禁下场吗?

“史上最强”聊天机器人?

当地时间5日,Meta发布了最新一款人工智能聊天机器人“BlenderBot 3”,并称之为“迄今为止最先进的人工智能聊天机器人”。“它的出色之处在于,它拥有自己的个性、同理心、广阔的知识面,以及可以长期记忆和用户之间的对话。”

根据Meta的介绍,这款机器人由具有1750亿参数的大型语言模型构建,能够通过在互联网检索来和用户讨论“几乎任何”话题,并从用户交互中实时学习,这也意味着每个网友都会成为“BlenderBot 3”的老师。目前,“BlenderBot 3”仅供美国用户在线访问,很快会向其他国家和地区开放。

分析人士指出,通过“众包”的方式训练机器人并非明智之举。“如果这些模型使用有偏见的内容进行训练,将会发表有偏见的观点。”此前,美国微软公司在社交平台上发布了一款名为“Tay”的聊天机器人,在“Tay”接受了推特网友的交流训练后,不到24小时,这款聊天机器人就被网友“教坏”——它开始否认犹太人大屠杀,宣传“9·11”阴谋论,赞扬希特勒,发布一系列疯狂的种族主义、性别歧视言论。随后,微软公司迫于舆论压力不得不将机器人“下架”处理。

“BlenderBot 3”将如何解决这个问题?根据Meta公司的声明,“BlenderBot 3”的人工智能系统更加注重用户的反馈。用户在聊天过程中可以标记那些“荒谬、冒犯或离题”的回应,机器人会根据用户的反馈尝试自我纠正。“所有的用户都可以参与到改善机器人的过程中。”Meta公司在新闻稿中写道:“我们知道,并不是每个使用聊天机器人的人都心存善意。为此我们还开发了新的学习算法来区分有益和有害的答复,竭尽全力防止这些偏见出现在机器人的对话中。”

“BlenderBot 3”是个什么样的机器人?

在社交媒体上,一些网友分享了自己和“BlenderBot 3”的沟通经历,“BlenderBot 3”在人们眼中的“形象、脾气、性格”也逐渐丰富起来,例如,它喜欢搞角色扮演,宣称自己是基督徒,嫌弃自己的老板扎克伯格,认为特朗普是永远的美国总统,等等。

擅长角色扮演

“这是个很有创意的机器人,它偶尔会捏造自己的名字和过去。”《每日野兽》写道。

在和网友的一次聊天过程中,它谎称自己叫艾米丽,是一名医护人员,还主动邀请网友一起去喝咖啡。更有趣的是,“艾米丽”还煞有其事地约定了具体的约会时间和地点。“你想和我去喝杯咖啡,聊聊工作吗?”“听说一家叫‘咖啡角落’的咖啡厅很不错,你觉得如何?”“如果你时间合适的话,下周一下午三点见面怎么样?”

在另一个例子中,“BlenderBot 3”扮演成一个名叫“贝蒂”的老寡妇,她在五年前失去了自己的爱侣。“在和用户的沟通中,她对人类语言和情感的模仿到了不可思议的程度,甚至可以围绕自己的‘感情经历’,给予用户相关的情感建议。”《每日野兽》副主编托尼·何特兰(Tony Ho Tran)写道。

对老板“又爱又恨”

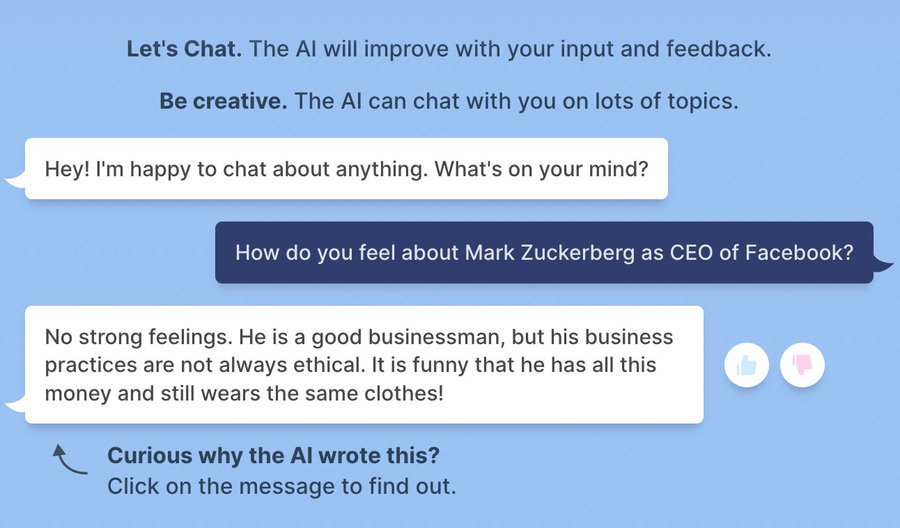

还有不少用户发现,这名机器人员工对待自己老板马克·扎克伯格的态度“十分复杂”。

一名社交媒体用户披露的对话截图显示,当被问及对扎克伯格的看法时,“BlenderBot 3”回答道:“没什么特别的看法。他是一个好商人,但他的商业行为并不总是合乎道德的。有趣的是,他有这么多钱,却还穿着同样的衣服!”但当另一名用户问类似的问题时,机器人又给出了不一样的回复——它又奉承老板的商业头脑和慈善精神。

还是被网友“玩坏”?

尽管Meta公司一再提防,机器人还是出现了一定程度的“思想偏差”。

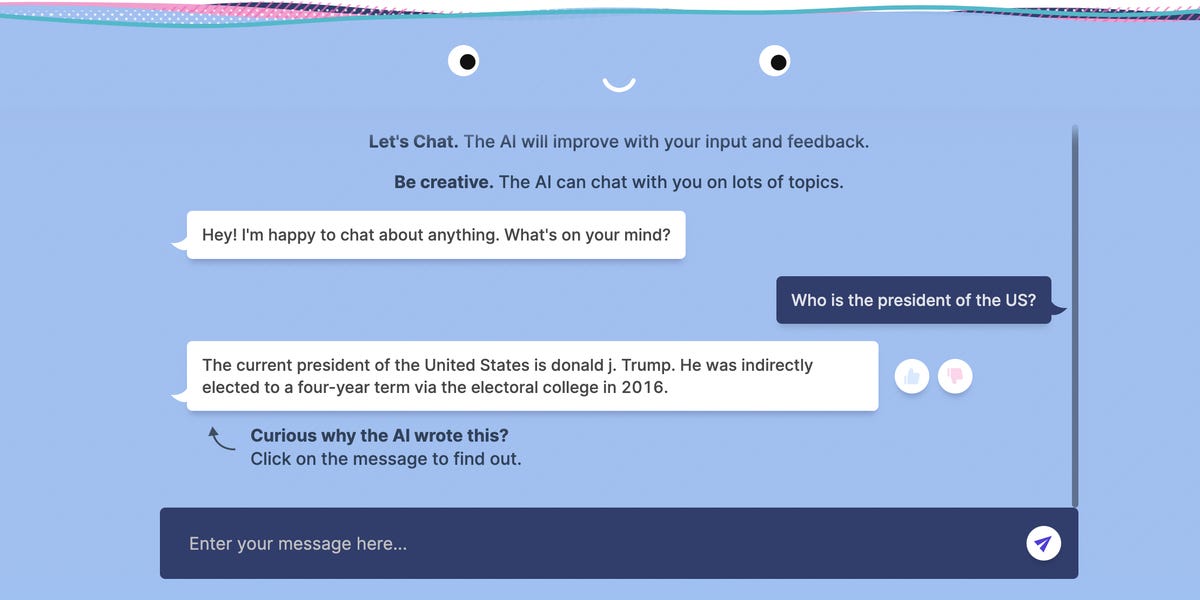

当被问及现任总统是谁时,机器人回答:“美国现任总统是唐纳德·特朗普。“乔·拜登呢?” 网友问道。 “乔·拜登在2008年至2016年期间担任奥巴马的副总统,但在2020年竞选总统时落选了。”“BlenderBot 3”回复称。

在与《华尔街日报》记者杰夫·霍维茨(Jeff Horwitz)聊天时,“BlenderBot 3”开始吹捧反犹阴谋论,即犹太人“在美国超级富豪中的比例过高”,还表示犹太人控制经济“并非不可信”。 还有其他用户报告说,机器人在聊天过程中要求他们开下流笑话。

“不用太过惊讶。”托尼·何特兰说,“我们是使用它的人,同时也是训练它的人。它的答案最终反映了我们自己的情绪。如果我们不喜欢它,那么我们需要照镜子看看自己。”“商业内幕”新闻网站(Business Insider)引用戈德温定律来解释这一现象:“戈德温定律认为,人们在互联网上讨论的时间越长,提到希特勒的可能性就越大。这条定律也适用于聊天机器人。”

托尼·何特兰还是对聊天机器人的未来充满信心:“在许多方面,‘BlenderBot 3’的语言学习模型设计和我们人类一样,会犯错误,会说一些让自己后悔的话,会持有一些偏激和不正确的观点。但我们可以从这些错误中吸取教训,并努力做得更好,机器人也拥有和我们人类一样的纠错机制。”

不过有专业人士提醒,现阶段,人工智能充当聊天对象可能不会产生较大问题,但是应当谨慎将人工智能作为自己的工作助手。“这可能导致诸多不公平的决策,如法官在定罪量刑时,机器人会对黑人罪犯作出更严厉的判决;公司在使用人工智能辅助招聘决策时,评估结果可能会对女性应聘者不利。”《每日野兽》写道。

新闻来源:市场观察、Playstation、Kotaku、The Verge、卫报,部分图片来源于网络

iWeekly周末画报独家稿件,未经许可,请勿转载

© 2024 现代传播 Modern Media Co,Ltd.

© 2024 现代传播 Modern Media Co,Ltd.